گروه صنعتی آسانسور و پله برقی بهران آسانبر

پروژه ها

نمونه هایی از پروژه های آسانسور و پله برقی بهران آسانبر

چرا باید ما را انتخاب کنید؟ این ویدیو را ببینید و خودتان تصمیم بگیرید.

گروه صنعتی آسانسور و پله برقی بهران آسانبر با بیش از سه دهه فعالیت در زمینه آسانسور و پله برقی بیشترین سابقه فعالیت را در زمینه آسانسور و پله برقی در سطح کشور داشته و جز اولین تولید کننده های قطعات آسانسور و پله برقی ایرانی میباشد.

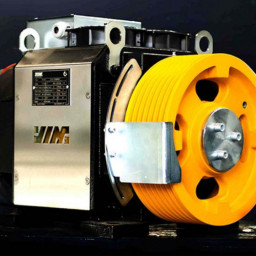

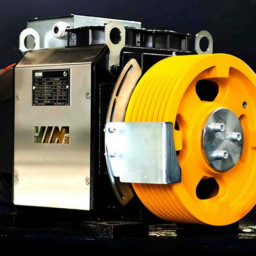

تماسباماقطعات آسانسور

انواع قطعات آسانسور مانند موتور گیربکس، موتور گیرلس، درب های اتوماتیک، نیمه اتوماتیک و لولایی، گاورنر، قلاب سیم بکسل و …

قطعات پله برقی

انواع قطعات آسانسور مانند موتور گیربکس، موتور گیرلس، درب های اتوماتیک، نیمه اتوماتیک و لولایی، گاورنر، قلاب سیم بکسل و …

پکیج آسانسور

انواع پکیج های آسانسور با موتورخانه، بدون موتورخانه و هیدرولیک برای فرودگاه ها، ایستگاههای مترو، مراکز اداری و تجاری، بیمارستانها، ساختمانهای مسکونی و …

پکیج پله برقی

انواع پکیج های پله برقی و شیبراه برای مراکز ترافیک بالا چون فرودگاه ها، ایستگاههای مترو، مراکز اداری و تجاری در مدل های تجاری، سخت کار و فوق سخت کار

آخرین خبرها

آخرین بیانیه های مطبوعاتی